AI Agent大模型技术全解析:原理、架构与未来趋势

作为一名深耕AI领域5年的技术观察者,最近半年我明显感受到行业热点的迁移——从“大模型能做什么”转向“大模型如何与其他技术深度融合”。而其中最让我兴奋的,莫过于AI Agent(智能体)与大模型的结合:前者让AI具备了“主动决策”的能力,后者赋予其“理解世界”的智慧,两者的碰撞正在重塑人机交互的边界。

如果你是开发者,想了解如何用大模型为智能体注入“灵魂”;如果你是企业技术决策者,在评估智能体产品的落地可行性;甚至如果你只是科技爱好者,好奇“能自己做决定的AI”到底如何工作——这篇文章都能为你拆解技术细节,还原AI Agent与大模型协同的底层逻辑。

一、AI Agent与大模型的底层原理:从感知到决策的进化

要理解两者的结合,首先得回溯技术演进的脉络。传统AI系统(如规则引擎、统计学习模型)更像“工具”,只能执行预设任务;而大模型的出现,让AI具备了“上下文理解”和“泛化能力”,但这仍停留在“被动响应”阶段。直到AI Agent概念的兴起,AI才真正开始向“主动决策”进化。

1.1 传统AI系统的局限性:从规则引擎到感知智能的瓶颈

早期AI系统依赖人工定义的规则库(如早期的聊天机器人),一旦遇到规则外的场景就“卡壳”;统计学习模型(如SVM、随机森林)虽能处理复杂数据,但需要大量标注数据训练,且难以适应动态变化的环境。即便是2017年Transformer架构提出后,大模型虽在自然语言处理(NLP)中表现惊艳,却始终缺少“目标驱动”的能力——它们能生成文本,却无法主动规划“如何生成更有用的文本”。

1.2 大模型的突破:上下文理解与泛化能力的质变

2023年以来,多模态大模型(如GPT-4、Gemini)和参数高效微调(PEFT)技术的成熟,让大模型具备了“持续学习”和“跨任务迁移”的能力。例如,Google的PaLM 2通过指令微调(Instruction Tuning),能理解用户的隐含需求(如“帮我总结这篇报告,重点突出市场增长率”);Meta的LLaMA 3则通过人类反馈强化学习(RLHF),优化了决策的合理性。这些能力为大模型与AI Agent的结合奠定了基础:大模型成为Agent的“大脑”,负责信息处理和决策推理。

1.3 AI Agent的决策链:感知-规划-执行的闭环逻辑

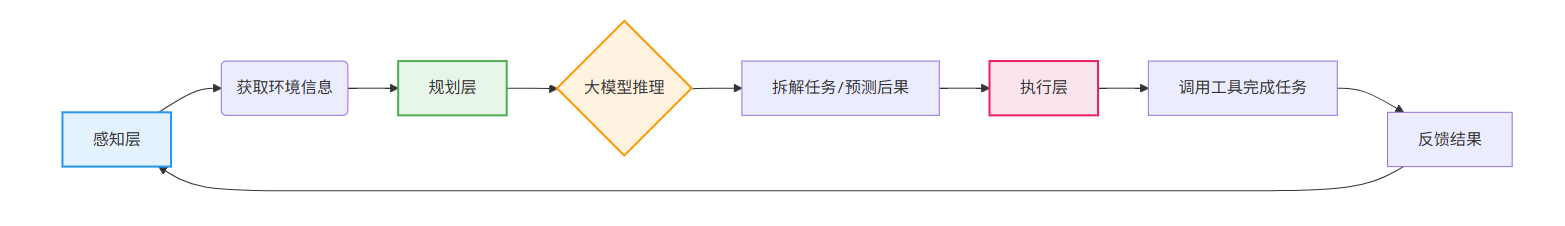

AI Agent的核心是“自主决策闭环”,其工作流程可拆解为三个阶段(如图1所示):

- 感知层:通过传感器、API或多模态输入(文本、图像、语音)获取环境信息;

- 规划层:基于大模型的推理能力,分析目标、拆解任务、预测行动后果;

- 执行层:调用工具(如搜索引擎、数据库、机器人)完成任务,并将结果反馈至感知层,形成迭代优化。

二、大模型驱动的AI Agent核心架构:模块拆解与协同机制

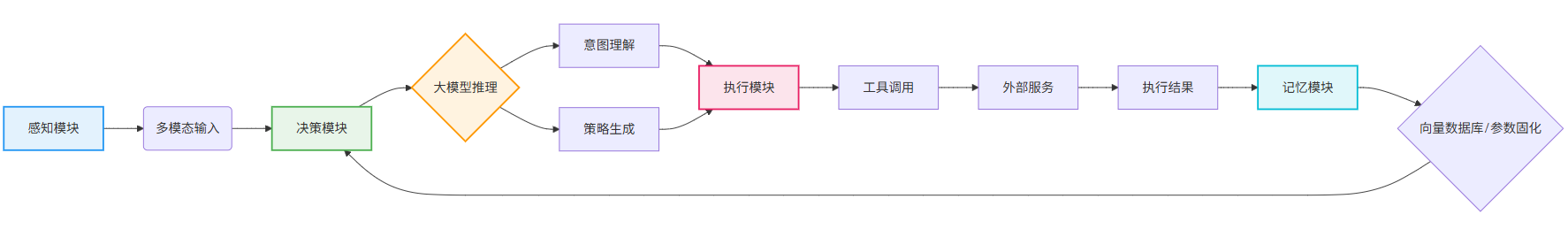

如果说原理是“为什么”,那么架构就是“怎么做”。AI Agent大模型系统的架构设计需平衡灵活性与效率,既要让Agent能适应不同场景,又要避免计算资源浪费。典型的架构可分为“感知模块”“决策模块”“执行模块”和“记忆模块”四大核心组件(如图2所示)。

2.1 感知模块:多模态输入的“神经末梢”

感知模块负责将外部信息转化为Agent能理解的“数据语言”。传统智能体的感知局限于单一模态(如文本或图像),而大模型的多模态能力让其能同时处理文本、语音、视频甚至传感器数据。例如,微软Copilot的桌面版支持“截图提问”——用户截取网页上的表格,Copilot能直接解析数据并生成图表,这背后就是多模态感知模块在起作用。

2.2 决策模块:大模型的“大脑中枢”

决策模块是Agent的核心,其性能直接决定了Agent的“智能水平”。大模型在此扮演两个关键角色:

- 意图理解:通过自然语言处理(NLP)技术,识别用户的显式需求(如“订明天的机票”)和隐含意图(如“希望选早班机,预算不超过1500元”);

- 策略生成:基于强化学习(RL)或符号推理(Symbolic Reasoning),生成最优行动策略。例如,在物流调度场景中,Agent需要考虑天气、交通、订单优先级等多重因素,大模型能快速计算出“先送紧急订单,再绕路避开拥堵”的方案。

2.3 执行模块:工具调用的“手脚”

执行模块是Agent与外部世界交互的接口,其本质是“工具库+调用引擎”。工具可以是通用API(如Google Search、天气服务),也可以是定制化的业务系统(如企业ERP)。大模型的“工具使用”(Tool Use)能力让Agent能动态选择最适合的工具:例如,当用户问“北京最近的新能源充电桩在哪里”,Agent会先调用地图API获取位置,再调用充电桩数据库筛选可用设备,最后通过文本生成模块返回结果。

2.4 记忆模块:长期学习的“经验仓库”

传统智能体的“记忆”是短期的(如对话历史),而AI Agent大模型系统的记忆模块需支持长期存储和快速检索。技术实现上,主要有两种方式:

- 向量数据库:将历史交互数据转化为向量,通过语义检索快速匹配相似场景(如用户之前问过“上海迪士尼门票价格”,下次问“上海迪士尼最新活动”时,Agent能关联推荐);

- 参数固化:将高频任务的决策模式固化到大模型的参数中,减少重复计算(如客服Agent处理“退货申请”时,直接调用已优化的流程模板)。

三、AI Agent与大模型融合的关键技术:注意力机制与记忆增强

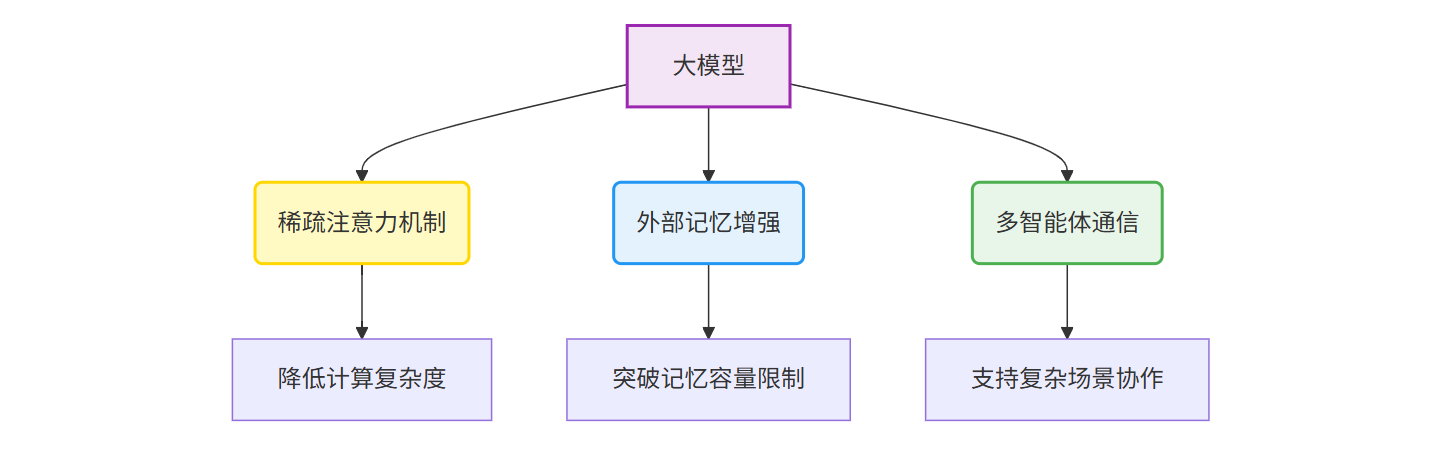

尽管大模型已具备强大的泛化能力,但其与AI Agent的结合仍需解决两大核心问题:长上下文处理的效率和多步决策的稳定性。近年来,学术界和工业界提出了多项关键技术,其中最具代表性的是“稀疏注意力机制”和“外部记忆增强”。

3.1 稀疏注意力机制:让大模型“聚焦关键信息”

传统Transformer的自注意力(Self-Attention)需要计算所有token之间的关系,时间复杂度为O(n²),当输入长度超过10万token时(如长文档、多轮对话),计算成本会指数级上升。稀疏注意力机制通过限制每个token仅与少量关键token交互(如局部窗口、固定间隔或任务相关token),将复杂度降至O(n)或O(n√n)。例如,Google的Retrieval-Augmented Generation(RAG)技术结合稀疏注意力,让大模型能高效处理长文档,这对需要分析财报、合同的商务Agent至关重要。

3.2 外部记忆增强:突破大模型的“记忆天花板”

大模型的参数容量有限(如GPT-3.5有1750亿参数,GPT-4约1万亿),无法存储所有历史交互数据。外部记忆增强技术通过引入独立的记忆存储(如向量数据库、键值对存储),将“长期记忆”与“短期记忆”分离:短期记忆由大模型的隐藏状态维护(处理当前对话),长期记忆由外部存储维护(记录历史行为)。例如,Anthropic的Claude 3通过“宪法记忆”(Constitutional Memory)模块,让Agent能记住用户设定的规则(如“不泄露隐私”),并在每次决策时检索相关记忆,确保行为一致性。

3.3 多智能体协作:从“单兵作战”到“团队协同”

复杂场景(如供应链管理、智能城市)需要多个AI Agent协作完成任务。大模型的“多智能体通信”(Multi-Agent Communication)技术通过设计专用通信协议(如基于自然语言的消息传递),让Agent能协商任务分工、共享中间结果。例如,在电商仓储场景中,库存管理Agent、订单处理Agent和物流调度Agent可通过大模型生成的“任务描述语言”交换信息,动态调整库存预警阈值或配送路线。

四、典型场景下的AI Agent大模型应用:从智能助手到工业决策

技术最终要落地到场景才有价值。目前,AI Agent大模型已在消费级和企业级市场展现出强大潜力,以下是最具代表性的三大应用场景:

4.1 消费级智能助手:从“回答问题”到“解决问题”

传统语音助手(如Siri、小爱同学)只能执行简单指令(如“设闹钟”“查天气”),而基于大模型的AI Agent已能处理复杂任务。例如,用户对Agent说:“下周三要去纽约出差,帮我订早上8点出发的航班,经济舱,预算1500美元,偏好靠窗座位,另外需要预订曼哈顿中城评分4.5以上的酒店,入住日期是下周三到周日。”Agent会自动调用航班查询API、酒店比价平台,甚至根据用户历史偏好(如“不喜欢红眼航班”)调整筛选条件,最终生成多个可选方案供用户确认。据Gartner预测,到2026年,70%的企业将为员工配备此类“个人AI Agent”。

4.2 客户服务Agent:从“标准化回复”到“个性化服务”

在客服领域,AI Agent大模型正在替代70%的基础咨询工作。以电商行业为例,BetterYeah AI Agent平台提供一站式的智能体开发服务,使得企业能够快速构建起符合自身需求的AI客服系统。在实际操作中,客服人员仅需在电商应用程序,如千牛、旺旺、抖店等中,打开与客户的对话内容,然后进行划词,BetterYeah AI Agent客服插件可自动调起企业的客服AI Agent应用,自动查询企业AI知识库,即可在秒级时间内识别问题,并提供企业标准答案。这种即时响应机制,不仅大幅降低了问题解决的时长,也显著提高了客服工作效率。根据实际使用数据显示,问题解决时间由原来的30秒至3分钟缩短至仅需15秒,日均接待量提升了10%至15%,AI问题解决准确率更是从40%飙升至95%,几乎提高了一倍。

4.3 工业决策Agent:从“经验驱动”到“数据驱动”

制造业的智能化转型中,AI Agent大模型正成为“数字工程师”。例如,某汽车制造厂的质检Agent能通过视觉大模型分析生产线摄像头的图像,识别零件表面的微小划痕(精度达0.1mm),并结合历史质量数据预测缺陷率;如果预测缺陷率超过阈值,Agent会自动调整生产参数(如模具温度、注塑压力),并向工程师发送预警。相关行业报告显示,这类工业Agent可将质检效率提升40%,缺陷率降低25%。

五、AI Agent大模型落地的挑战与破局路径:工程化与伦理平衡

尽管前景广阔,AI Agent大模型的大规模落地仍面临两大挑战:技术工程化和伦理风险。

5.1 技术工程化:从实验室到生产环境的“最后一公里”

实验室中的大模型在复杂场景下常出现“翻车”:例如,处理多轮对话时“忘记”前文信息,调用工具时因参数错误导致任务失败。解决这些问题需要“工程化优化”:

- 轻量化部署:通过模型压缩(如量化、剪枝)和边缘计算,让Agent能在手机、IoT设备等终端运行(如手机端的智能助手Agent);

- 容错机制设计:为Agent添加“自我校验”模块,当检测到异常(如工具调用失败、决策结果矛盾)时,自动触发重试或人工干预;

- 持续学习能力:通过在线学习(Online Learning)技术,让Agent能从用户反馈中不断优化(如客服Agent根据用户满意度评分调整回复策略)。

5.2 伦理风险:自主决策的“责任边界”

当AI Agent能独立完成决策(如自动下单、调整生产参数),其行为的“责任主体”变得模糊:如果Agent因算法偏见拒绝用户贷款申请,责任该归开发者、企业还是模型本身?目前,全球主要经济体已开始制定相关法规:欧盟的《人工智能法案》要求高风险AI系统(如医疗诊断、金融风控)必须“可解释”;美国NIST的《AI风险管理框架》强调“透明性”和“人类监督”。技术层面,解决方案包括:

- 可解释性增强:通过注意力可视化(Attention Visualization)技术,展示Agent决策的关键依据(如“拒绝贷款是因近3个月逾期次数超过2次”);

- 人类最终决策权:在高风险场景中,Agent仅提供建议,最终决策由人类确认(如自动驾驶汽车的“接管按钮”)。

总结:AI Agent大模型——人机协同的“智能引擎”

如果把AI技术的发展比作一场“进化之旅”,那么AI Agent大模型就是这场旅程中的“关键突变”:它让AI从“工具”升级为“伙伴”,从“被动响应”进化为“主动决策”。未来,随着多模态大模型的进一步突破、边缘计算的普及,以及伦理规范的完善,AI Agent将深度渗透到生活的每个角落——它可能是你的“个人助理”,帮你规划旅行;也可能是企业的“数字大脑”,优化供应链;甚至可能是城市的“智能管家”,协调交通、能源和公共服务。

正如计算机科学家Alan Kay所说:“预测未来的最好方式是创造它。”而AI Agent大模型,正是我们创造智能未来的重要工具。