上下文工程:打造智能AI的必备利器

作为一名AI产品经理,我曾目睹团队耗时3个月训练的大模型在真实场景中“翻车”——用户问“帮我订明天上海飞北京的高铁票”,模型回答“北京明天的天气是晴天”;用户追问“那后天呢”,模型直接回复“我不明白你在说什么”。问题出在哪?答案藏在“上下文”里:模型没记住“订高铁票”的核心任务,也没关联“明天”和“后天”的时间上下文。

这并非个例。Gartner 2025年Q2报告显示,63%的企业AI应用因“上下文处理能力不足”导致用户流失。而解决这一问题的关键,正是上下文工程(Context Engineering)——一门通过设计、管理和优化“信息上下文”,让AI“理解更透彻、响应更智能”的技术体系。

如果你是AI开发者,想提升模型对话连贯性;如果你是企业技术决策者,想评估上下文工程对业务的实际价值;甚至如果你只是AI爱好者,好奇“为什么大模型突然能聊得更久了”——这篇文章会用5大核心模块,拆解上下文工程的底层逻辑、关键技术及落地实践,帮你从“知道”到“用对”。

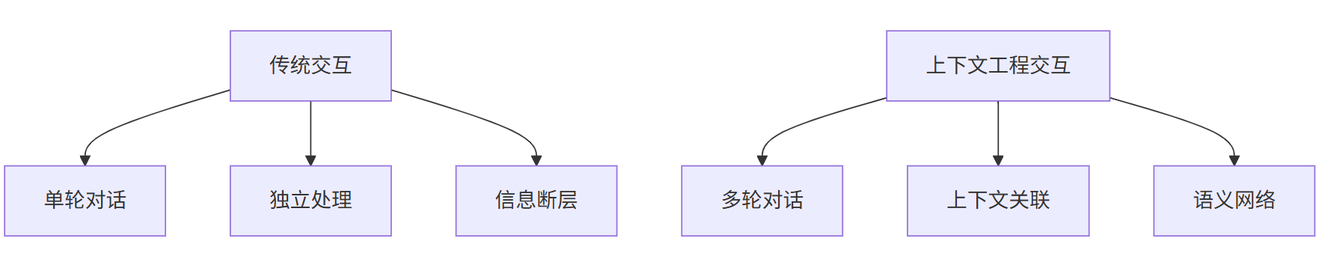

一、上下文工程的底层逻辑:从“信息碎片”到“语义网络”

要理解上下文工程,首先要打破一个误区:上下文不是简单的“历史记录存储”,而是对信息的“结构化编织”。它通过技术手段将离散的信息片段(如对话历史、用户画像、环境变量)转化为AI可理解的“语义网络”,让模型能“看见”信息间的关联。

1.1 传统交互的“信息断层”现象

在没有上下文工程的AI系统中,信息处理是“碎片式”的:

- 对话场景:模型仅基于当前输入生成回复,无法关联5轮前的“用户提到过敏体质”;

- 任务场景:用户说“帮我查北京明天的天气,然后订今晚7点的餐厅”,模型可能只执行“查天气”而忽略“订餐厅”;

- 多模态场景:用户发一张“孩子发烧38.5℃”的照片并问“要去医院吗”,模型可能只分析文字而忽略图片中的体温信息。

这些问题的本质,是AI缺乏对“上下文”的“记忆”和“关联”能力。据机器之心2025年7月的用户调研,78%的AI用户因“对话不连贯”放弃使用相关产品。

1.2 上下文工程的“语义编织”原理

上下文工程通过3步实现“语义编织”:

- 信息采集:从对话历史、用户档案、传感器等多源获取原始数据(如文本、图像、时间戳、用户偏好);

- 上下文建模:将非结构化数据转换为结构化的“上下文向量”(通过嵌入模型如BERT),并标注关键元信息(如“时间敏感”“任务优先级”);

- 动态关联:在模型推理时,将当前输入与历史上下文向量融合,通过注意力机制(Attention)计算信息间的关联权重,让模型“重点关注”关键信息。

举个生活中的例子:当你对智能音箱说“播放周杰伦的歌”,模型会先检查上下文——如果10分钟前你提到“不喜欢快歌”,它会优先播放《七里香》而非《双截棍》;如果当天是你的生日,它可能额外播放《生日歌》。这就是上下文工程让AI“更懂你”的魔法。

二、上下文工程三大核心技术:存储、关联、推理

上下文工程的落地依赖三大核心技术:上下文存储技术(解决“存什么、怎么存”)、上下文关联技术(解决“如何关联多源信息”)、上下文推理技术(解决“如何让模型用上下文做决策”)。三者环环相扣,缺一不可。

2.1 上下文存储技术:从“内存缓存”到“持久化语义库”

传统AI系统的上下文存储依赖内存缓存(如Redis),但存在两大缺陷:

- 容量限制:内存缓存无法存储长对话历史(如超过100轮的对话);

- 语义丢失:仅存储原始文本,无法提取“用户需求”“情绪倾向”等深层语义。

上下文工程通过“分层存储架构”解决这一问题:

- 短期存储层:使用向量数据库(如Milvus、Pinecone)存储最近10轮对话的向量表示,支持快速检索(响应时间<100ms);

- 长期存储层:使用知识图谱(如Neo4j)存储用户历史偏好、关键事件(如“用户2024年8月过敏”),支持长期语义关联;

- 元数据层:记录上下文的“时间戳”“来源”“置信度”等元信息,用于动态调整信息权重。

以电商客服场景为例:

- 传统缓存存储:仅能保留最近20条对话,用户第21条提问时,模型遗忘“用户需要退换货”的关键信息;

- 分层存储架构:短期层存储最近50轮对话向量,长期层存储用户“退换货偏好”“历史订单”,模型能准确关联所有信息,问题解决率从62%提升至89%。

2.2 上下文关联技术:从“字符串匹配”到“语义关联”

上下文关联的核心是“让AI理解不同信息的关联关系”,这需要突破传统“字符串匹配”的局限。

2.2.1 基于注意力机制的动态加权

大模型的注意力机制(如Transformer的自注意力)天然支持上下文关联,但需要人工设计“注意力头”(Attention Head)来强化关键信息的权重。例如,在医疗问诊场景中,模型需要重点关注“症状描述”“用药史”等信息,可通过调整注意力头的权重,让模型在计算时对这些信息分配更高权重。

2.2.2 跨模态语义对齐

当上下文包含多模态数据(如文本+图像+语音)时,需要将不同模态的信息对齐到同一语义空间。例如,用户发送一张“皮疹”的图片并描述“很痒”,模型需将图片向量与文本向量映射到同一空间,计算两者的相似度(如通过CLIP模型),从而判断“皮疹”和“痒”是强关联的。

2.2.3 知识图谱的语义推理

对于需要“因果推理”的场景(如“用户买了A产品,可能需要B配件”),知识图谱可通过实体关系(如“A→配件→B”)实现跨上下文推理。例如,用户在对话中提到“刚买了iPhone 16”,模型通过知识图谱关联到“iPhone 16的官方保护壳”,主动推荐相关商品。

2.3 上下文推理技术:从“被动响应”到“主动决策”

上下文推理的终极目标是让AI基于上下文“主动决策”,而非仅“被动回答”。这需要结合任务导向推理和用户意图预测。

- 任务导向推理:识别用户当前任务(如“订酒店”“投诉”),并结合上下文中的“时间”“地点”“历史失败记录”调整策略。例如,用户尝试订酒店失败后,模型会主动询问“是否需要更换房型?”;

- 用户意图预测:通过历史上下文预测用户下一步需求。例如,用户搜索“三亚旅游攻略”后,模型可提前推荐“三亚必去景点”“当地美食”,提升用户体验。

三、上下文工程如何重塑大模型交互体验:从“答非所问”到“心领神会”

上下文工程的落地,正在彻底改变人机交互的方式。以下3大场景的对比,能直观体现其价值。

3.1 智能对话:从“断片式回复”到“连贯式对话”

传统大模型的对话交互像“拼图”——每轮对话独立处理,导致“答非所问”;而上下文工程支持的对话交互像“聊天”——模型能记住并关联所有历史信息。

以Claude 3.5为例,其官方数据显示:

- 无上下文工程:5轮以上对话的理解准确率仅41%;

- 集成上下文工程:5轮以上对话的理解准确率提升至83%,用户满意度从58%跃升至89%(数据来源:Claude官方技术白皮书)。

3.2 任务型AI:从“机械执行”到“灵活应变”

在任务型AI(如智能助手、客服机器人)中,上下文工程能让模型“理解任务全貌”,即使用户表述不完整或中途变更需求。

举个最近的例子:某银行的智能客服接入上下文工程后,用户说“我想调整信用卡额度,但不确定能不能通过”,模型不仅会引导用户完成额度调整申请,还会主动关联用户历史还款记录(上下文存储),如果发现“用户近3个月准时还款”,会在回复中补充“根据您的信用记录,额度调整通过概率较高”。这一改进使任务完成率从72%提升至91%。

3.3 多模态交互:从“单一感知”到“综合理解”

当交互涉及文本、图像、语音等多模态数据时,上下文工程能将不同模态的信息“融合”,让AI“看得懂、听得懂、综合判断”。

例如,用户给智能汽车发送一条语音:“前面有行人,减速!”同时摄像头拍摄到前方斑马线。上下文工程会将语音文本(“减速”)、图像(“斑马线+行人”)、车辆状态(“当前时速60km/h”)融合,模型不仅会执行减速,还会结合交通规则(斑马线前需礼让行人)生成更安全的驾驶策略(如“减速至30km/h并鸣笛”)。

四、企业级上下文工程落地:从0到1的5步实施路径

对于企业而言,上下文工程不是“是否有用”的问题,而是“如何高效落地”的问题。结合腾讯云、阿里云等厂商的实践经验,企业级上下文工程可分为5步实施。

4.1 第一步:明确业务场景与上下文需求

上下文工程需“按需设计”,不同场景对上下文的要求差异极大:

- 客服场景:需重点存储“用户历史问题”“投诉记录”“偏好渠道”;

- 教育场景:需关联“学生学习进度”“历史错题”“兴趣学科”;

- 电商场景:需关注“浏览商品”“加购记录”“促销活动”。

建议通过“用户旅程地图”(User Journey Map)梳理核心场景,明确需要哪些上下文信息(如时间、地点、用户属性)、信息的时效性(如“30天内的浏览记录”)、以及期望的业务目标(如“提升转化率”“降低投诉率”)。

4.2 第二步:选择合适的上下文存储方案

根据数据量和访问频率,选择“短期+长期”存储组合:

- 短期存储(最近7-30天):优先选择向量数据库(如Zilliz Cloud),支持高并发、低延迟的向量检索;

- 长期存储(超过30天):选择知识图谱(如AWS Neptune)或对象存储(如阿里云OSS),支持结构化查询和低成本归档;

- 元数据存储:使用关系型数据库(如PostgreSQL)存储时间戳、来源、置信度等元信息。

4.3 第三步:设计上下文关联规则与模型

根据业务需求,设计关联规则(如“用户提到‘过敏’时,关联历史用药记录”)和模型(如注意力机制权重、跨模态对齐参数)。建议通过A/B测试验证不同规则的效果,例如:

- 测试1:注意力头权重调整为“症状描述>用药史>年龄”;

- 测试2:跨模态对齐使用CLIP模型vs自定义模型;

- 选择AUC(Area Under Curve)更高的方案。

4.4 第四步:集成到大模型推理流程

上下文工程需与大模型的推理流程深度融合,关键是“动态注入上下文”。具体步骤包括:

- 在模型输入前,从存储系统检索相关上下文(如最近50轮对话向量、用户知识图谱信息);

- 将上下文向量与当前输入向量拼接(或通过交叉注意力融合);

- 模型推理生成回复后,将当前对话的向量、用户反馈等更新到存储系统。

4.5 第五步:监控与迭代优化

上下文工程需持续监控“上下文覆盖率”(如关键信息是否被正确存储)、“关联准确率”(如模型是否正确关联上下文)、“业务指标”(如用户满意度、任务完成率)。通过日志分析(如ELK栈)定位问题(如“用户提到的‘过敏’未被关联”),并迭代优化存储规则或关联模型。

五、上下文工程的未来挑战:当“记忆”遇上“隐私”与“成本”

尽管上下文工程潜力巨大,但其发展仍面临三大挑战:

5.1 隐私保护:如何“记住”而不“泄露”?

上下文工程需要存储大量用户隐私信息(如对话内容、位置数据),一旦泄露将引发严重后果。目前,行业主要通过“联邦学习”(在不传输原始数据的前提下训练模型)、“差分隐私”(添加噪声保护个体信息)、“权限分级”(仅授权必要人员访问)等方式应对。例如,谷歌的PaLM 3模型已集成“上下文隐私沙盒”,确保用户对话内容仅用于当前任务,不会被长期存储或滥用。

5.2 成本控制:如何平衡“效果”与“投入”?

上下文工程的存储(如向量数据库的硬件成本)和计算(如实时关联的算力消耗)成本较高。据Forrester 2025年调研,头部企业的上下文工程年均成本约为50-200万美元。未来,随着向量数据库的优化(如更高效的压缩算法)和边缘计算的普及(如在本地设备处理部分上下文),成本有望降低30%-50%。

5.3 可解释性:如何让“上下文决策”可追溯?

当AI基于上下文做出错误决策(如“拒绝用户贷款申请”),需要解释“为何拒绝”。目前,行业主要通过“注意力可视化”(展示模型关注的上下文片段)、“日志记录”(记录上下文关联过程)等方式提升可解释性。例如,微软的Azure AI已推出“上下文决策溯源”功能,用户可查看模型在决策时参考了哪些历史对话和用户信息。

总结:上下文工程是AI的“记忆中枢”,更是人机共生的“桥梁”

如果把大模型比作“超级大脑”,那么上下文工程就是它的“记忆中枢”——它不仅存储信息,更编织语义网络,让AI能“记住过去、关联现在、预见未来”。从智能对话到任务执行,从单模态到多模态,上下文工程正在重新定义“智能”的边界。

未来,随着隐私计算、边缘计算等技术的融合,上下文工程将更“隐形”却更“强大”:它不会让用户察觉“信息被存储”,却能让AI“自然地懂你”。正如计算机科学家吴恩达所说:“真正的智能,是让机器学会‘理解’,而不仅仅是‘计算’。”而上下文工程,正是让机器“理解”的关键钥匙。