2026年智能体LLM选择指南:从GPT-4o到开源模型的全面对比

近期有关于智能体,也就是AI Agent 的讨论在行业当中明显增多。从企业级应用以及个人助手这两个方面来看,智能体正在成为AI落地的新风口。鉴于市面上存在几十种大语言模型,开发者在选型方面经常会遇到一个头疼的问题,也就是到底要选用哪个LLM来构建智能体。

根据IDC MarketScape中国智能体开发平台2025年厂商评估的最新数据,有64%的中国企业已经在进行测试或者计划去部署AI智能体。这样一来就意味着LLM的选择不再仅仅是技术层面的问题,而是会直接关系到项目成败的战略性决策。

本文将提供一份基于2025年最新数据来开展的智能体LLM选择指南,内容包括从商业模型以及开源方案两个方面所进行的全面对比分析。

一、2026年智能体开发主流LLM模型全景

先给出结论:在当前的智能体开发领域,当中真正需要重点考虑的LLM可以被划分为三个梯队。

第一梯队(综合能力最强):

- GPT-4o - OpenAI的旗舰模型,在推理以及工具调用方面的能力较强

- Claude 3.5 Sonnet - Anthropic出品,编程能力方面表现突出

- Gemini 1.5 Pro - Google的多模态专家

第二梯队(性价比优秀):

- DeepSeek-V3 - 开源模型当中的佼佼者,在推理能力方面接近GPT-4

- Qwen2.5-Max - 阿里云出品,在中文场景当中的表现较为优异

- GLM-4.5 - 智谱AI选用为智能体进行优化的模型

第三梯队(特定场景专用):

- Llama 3 - Meta开源,生态方面较为完善

- 文心一言4.0 - 百度出品,在中文理解方面具备一定优势

根据中国信通院智能体技术和应用研究报告的分析可以看到,大模型会为智能体提供强大的自然语言理解以及生成能力,但是不同模型在推理链、工具调用、多轮对话这些关键能力方面存在较为显著的差异。

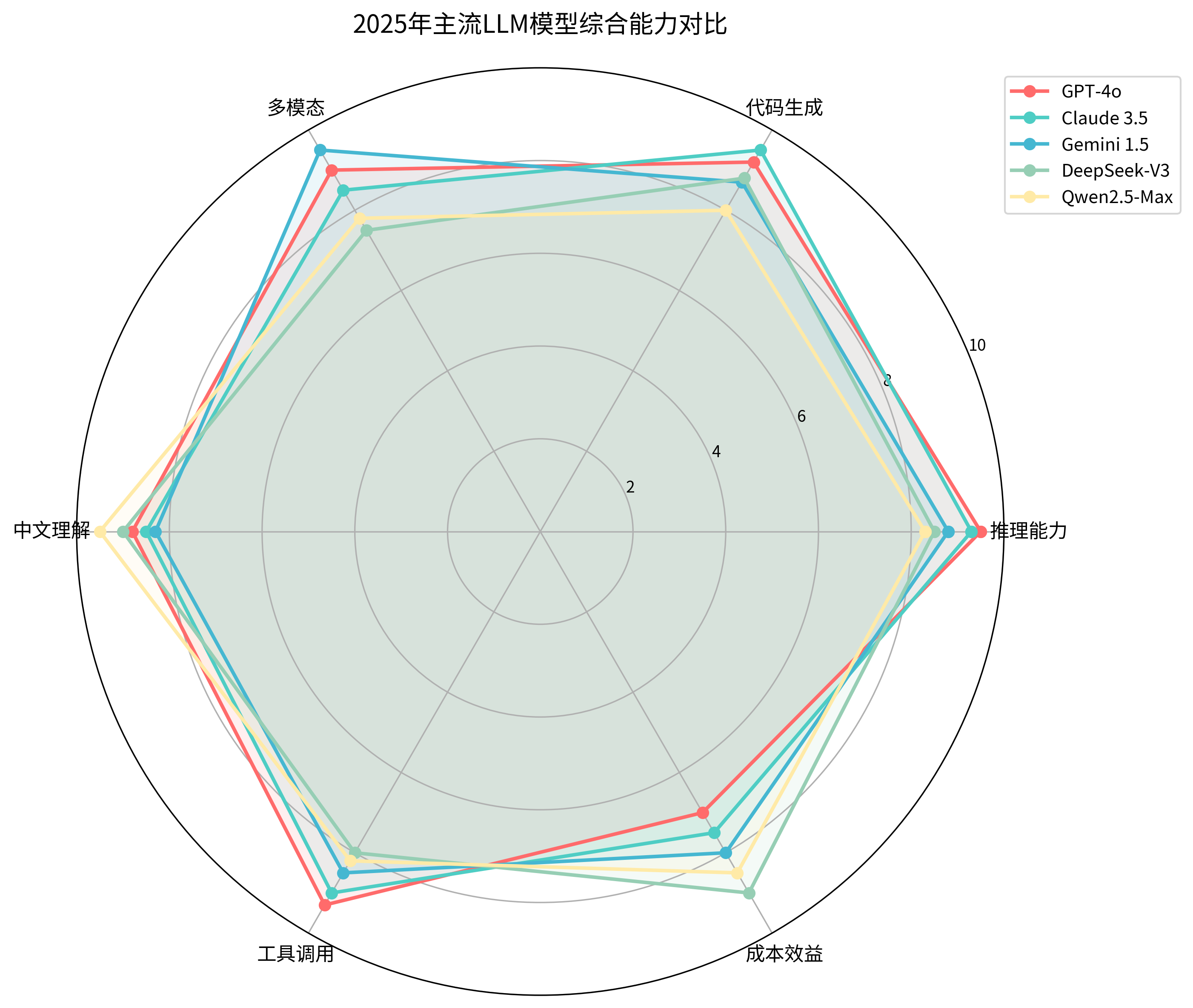

图:2026年主流LLM模型综合能力对比

从雷达图可以看出,GPT-4o在推理能力以及工具调用方面依然处于领先位置,但是在成本效益方面的表现相对不如开源模型。这样一来就带出了一个关键问题,也就是商业模型的价格是否具备足够的价值。

二、商业级LLM:GPT-4o、Claude 3.5与Gemini Pro深度对比

核心点在于,需要选用什么样的智能体能力。

GPT-4o:工具调用之王

核心优势:

- Function Calling准确率可以达到96.8%,在复杂智能体场景当中具有重要意义

- 支持128K的上下文长度,适宜需要保留大量历史记录的对话型智能体

- API稳定性较好,有99.9%的可用性保证

适用场景:

- 企业级客服智能体

- 需要频繁调用外部API的业务流程自动化

- 对准确性要求较高的专业咨询智能体

局限性:在成本方面偏高。对于高频调用的场景,每月API费用可能会达到数万元。

Claude 3.5 Sonnet:代码生成专家

核心优势:

- 在代码生成能力方面处于业界较高水平,HumanEval测试得分为92.3%

- 上下文理解能力较强,适合需要理解复杂业务逻辑的智能体

- 安全性考虑较为周全,拒答机制相对温和

适用场景:

- 编程助手智能体

- 需要生成复杂工作流的自动化智能体

- 内容创作以及文档生成智能体

局限性:在中文场景当中的稳定性不如GPT-4o,尤其是涉及中国特色业务场景的时候。

Gemini 1.5 Pro:多模态全能选手

核心优势:

- 在多模态处理能力方面较为强劲,支持文本、图像、视频以及音频

- 支持200万token的超长上下文,适合去处理大量文档

- 与Google生态的集成度较高

适用场景:

- 需要处理图像以及文档的智能体

- 内容审核以及分析类智能体

- 教育培训类智能体

局限性:API响应速度相对偏慢,在需要进行实时交互的场景下体验不佳。

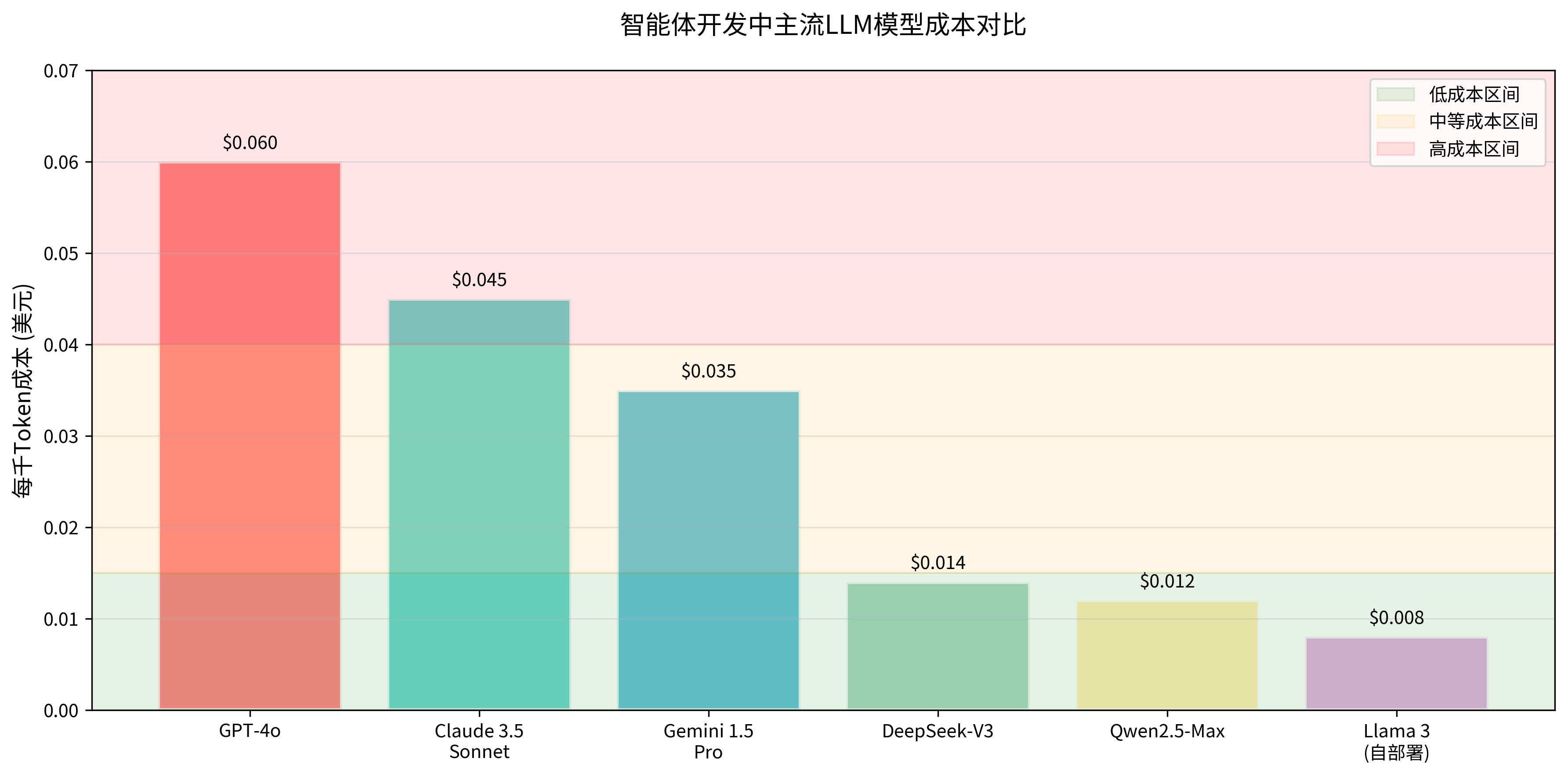

成本对比:实际情况

图:智能体开发中主流LLM模型成本对比

从成本的角度来看,商业模型的价格差异较大。要是智能体的日处理量超过10万次对话,GPT-4o的月费用可能会超过3万元人民币。这个时候,开源模型就会显得更有吸引力。

三、开源LLM在智能体开发中的优势与选择

从当前情况来看,2025年的开源LLM已经不再等同于“便宜没好货”的认知。

DeepSeek-V3:开源模型的突破

性能表现:

- 在推理能力方面接近GPT-4水平,在数学以及逻辑推理测试中得分为85.2%

- 支持多语言,在中英文两个方面的表现较为均衡

- 进行了模型架构优化,推理速度相较于同等规模模型可以快40%

部署优势:

- 支持4-bit量化,可以在单卡V100上进行部署

- 属于完全开源形态,不存在API调用限制

- 社区较为活跃,文档以及示例较为丰富

实际应用:在实际应用当中,已有不少企业选用DeepSeek-V3去构建内部知识问答智能体,在保证数据安全的同时,成本可以控制在商业API的十分之一以下。

Qwen2.5-Max:中文场景的王者

核心优势:

- 在中文理解能力方面表现较强,C-Eval测试得分为94.1%

- 针对中国用户习惯进行了优化,可以更好地理解语境以及文化背景

- 阿里云会提供较为完整的部署以及运维支持

适用场景:

- 面向中国用户的客服智能体

- 中文内容创作以及编辑智能体

- 需要理解中国商业环境的业务流程自动化

开源vs商业:权衡之道

| 对比维度 | 商业模型 | 开源模型 |

|---|---|---|

| 性能表现 | GPT-4o > Claude 3.5 > Gemini Pro | DeepSeek-V3 > Qwen2.5-Max > Llama 3 |

| 成本控制 | 成本较高且弹性不强 | 主要是部署以及运维成本 |

| 数据安全 | 需要依靠厂商的承诺 | 完全可控,可以进行私有化部署 |

| 定制能力 | 主要依靠Prompt工程 | 支持微调以及架构修改 |

| 技术门槛 | 进行API调用即可开始 | 需要具备MLOps以及模型部署能力 |

| 服务稳定性 | 由厂商SLA进行保证 | 依赖自建的运维体系来保障 |

决策法则:要是团队在AI基础设施方面能力不足,并且对成本不敏感,那么可以选用商业API。要是具备一定技术实力并且重视数据安全,那么开源模型会更适宜。

在这个选择过程中,像BetterYeah AI这样的智能体开发平台会显得较为有价值,它支持多种LLM的无缝集成,可以根据不同场景进行灵活切换模型,而不需要把整个智能体架构进行重写。

四、基于应用场景的LLM选择决策框架

关键在于,需要依据具体应用场景来进行选择。这里总结出一个较为实用的决策框架。

场景一:企业级客服智能体

需求特征:

- 高并发处理,日均10万次以上对话

- 多轮对话能力较强

- 需要调用CRM、订单系统这些外部接口

- 对响应准确性有较高要求

推荐方案:

- 首选:GPT-4o 加专业智能体开发平台

- 备选:Claude 3.5 Sonnet,在成本敏感时选用

- 开源方案:DeepSeek-V3 加进行自建部署,适合技术实力较强的团队

场景二:代码生成与开发助手

需求特征:

- 对代码生成准确性要求较高

- 需要去理解较为复杂的技术文档

- 需要支持多种编程语言

- 能够进行代码审查以及给出优化建议

推荐方案:

- 首选:Claude 3.5 Sonnet

- 备选:GPT-4o,在预算充足时选用

- 开源方案:DeepSeek-V3,适合对数据安全要求较高的企业

场景三:内容创作智能体

需求特征:

- 需要较强的中文写作能力

- 能够理解行业专业知识

- 支持多种内容格式

- 对创意以及原创性有一定要求

推荐方案:

- 中文场景:Qwen2.5-Max 或 GLM-4.5

- 多语言场景:GPT-4o

- 成本敏感:DeepSeek-V3

场景四:多模态分析智能体

需求特征:

- 需要处理图像、文档以及视频

- 进行跨模态理解以及推理

- 对大文档处理能力有一定要求

- 实时性要求相对较低

推荐方案:

- 首选:Gemini 1.5 Pro

- 备选:GPT-4o,在图像处理较为简单的时候选用

- 开源方案:暂无完全对等的开源替代

决策流程图

加载图表中...

成本效益分析框架

对于企业决策者,建议选用如下较为简明的ROI计算方式:

智能体LLM总成本 = API调用成本 + 开发成本 + 运维成本 + 风险成本

- API调用成本:按照实际使用量进行计算

- 开发成本:包括集成时间以及人力成本

- 运维成本:包括监控、优化以及故障处理

- 风险成本:涉及数据泄露以及服务中断的潜在损失

根据在实际项目当中的经验观察,当日调用量超过5万次的时候,开源模型的总体拥有成本通常会比商业API低60%到80%。前提条件是需要具备相应的技术团队。

要是企业在AI基础设施建设能力方面存在不足,那么选择像BetterYeah AI这类企业级智能体开发平台会更为稳妥,它会提供多LLM兼容、低代码开发以及企业级安全部署的完整解决方案。

写在最后:选择比努力更重要

LLM选择的本质是一个工程问题,而不是单纯的技术问题。

最合适的模型并不等同于性能最强的模型,而是需要契合具体场景的模型。GPT-4o虽然较强,但是要是智能体主要服务的是中文用户,那么Qwen2.5-Max可能会更适宜。Claude 3.5在代码能力方面较为出众,但是要是不需要进行代码生成,那么这个优势的价值就会降低。

同时还需要看到,LLM技术的发展速度较快。今天的较优选择,可能在三个月之后会被新的模型去超越。因此,把智能体架构进行灵活设计,使其可以快速地去切换以及测试不同模型,会比一开始就选对模型更有价值。

需要明确的一点是,工具是为了能够去解决问题而存在的。应该先把需要解决的问题进行明确,然后再去选用合适的LLM。这样就不会在技术选型方面浪费时间,而是可以把精力投入到真正能够创造价值的工作当中。