大模型agent工作流常见误区:调度冗余、上下文丢失如何避坑?

引言:当大模型agent从“概念”走向“落地”,我们踩过的那些坑

去年帮一家电商客户搭建智能客服agent工作流时,他们兴奋地说:“终于能用大模型自动处理90%的客户咨询了!”但上线两周后,客服主管气冲冲地找我:“系统每天生成2000条重复回复,客户投诉率反而涨了30%——这agent是‘智障’吗?”

这并非个例。随着大模型技术的普及,越来越多的企业和开发者开始尝试将agent工作流落地到客服、营销、研发等场景,但实际运行中,“调度冗余导致资源浪费”“上下文丢失让对话断片”“目标偏移让任务南辕北辙”等问题频繁出现。作为亲历过10+企业agent工作流搭建的从业者,我深刻意识到:大模型agent不是“搭个框架就能跑”的玩具,而是需要精准规避误区的“精密仪器”。

今天,我们就聚焦最易踩坑的三大场景——调度冗余、上下文丢失、目标偏移,结合2025年最新行业数据和一线实战案例,拆解每个误区的底层逻辑、识别方法与解决方案,帮你从“踩坑选手”变身“避坑高手”。

一、大模型agent工作流的三大典型误区:调度冗余、上下文丢失与目标偏移

在实际落地中,这三个误区就像“隐藏炸弹”,轻则让agent效率打折,重则导致项目流产。我们先通过一组数据感受问题的普遍性:

根据《企业级大模型应用成熟度报告》,73%的企业在agent工作流部署中遇到过“调度冗余”问题,其中38%的企业因此增加了20%以上的算力成本;IDC同期调研显示,上下文丢失导致的任务失败率高达30%,在金融、医疗等对信息准确性要求高的场景中,这一比例甚至升至50%;而目标偏移问题,更是让42%的企业在试点阶段就放弃了规模化推广。

1.1 调度冗余:agent为何总在“无效忙碌”?

调度冗余是指agent在工作流中重复触发任务、空转资源,或在不必要的节点反复执行相同操作的现象。举个真实案例:某教育机构的智能辅导agent,本应针对学生错题生成个性化练习,但上线后发现它会每隔10分钟重复推送同一道题——因为系统没有记录“该题已推送”的状态,导致调度逻辑陷入死循环。

1.1.1 调度冗余的三大表现形式

- 任务重复触发:同一任务因状态未标记被多次调用(如上述教育机构案例);

- 资源空转等待:agent因依赖的上游数据未就绪而“原地等待”,浪费算力;

- 路径错误绕路:本应直线完成的流程,因规则配置错误导致agent“绕远路”(例如本应调用A模型的任务错误调用了B模型)。

1.1.2 技术根源:状态感知缺失与奖励机制错配

从技术层面看,调度冗余的核心问题在于agent对“自身状态”和“环境状态”的感知能力不足。大模型本身没有“记忆”,需要通过外部存储(如数据库、向量数据库)记录任务状态,但如果状态标记规则设计模糊(例如未明确“已完成”的判定标准),agent就无法判断是否需要重复执行任务。此外,部分团队为了提升响应速度,错误地将“快速响应”作为唯一奖励指标,导致agent倾向于“重复简单操作”而非“解决复杂问题”。

图1:调度冗余的三大表现形式及技术根源

二、调度冗余的底层逻辑:为什么你的agent总在“重复劳动”?

要解决调度冗余,首先得理解它的“生存土壤”。我们结合《大模型agent工作流技术白皮书》,总结出三大技术根源:

2.1 状态管理系统的“先天缺陷”

目前主流的agent框架(如LangChain、AutoGen)依赖外部存储记录状态,但如果存储结构设计不合理(例如用简单的键值对存储复杂任务状态),agent无法准确获取“任务进行到哪一步”的信息。例如,某金融风控agent需要同时跟踪用户基本信息、交易记录、历史风险评分三个维度的状态,若存储时仅用“user_id”作为键,就会导致状态混淆,agent不得不重复查询基础信息。

2.2 任务拆解的“颗粒度失控”

很多团队在搭建工作流时,习惯将大任务直接拆解为“第一步-第二步-第三步”,但未考虑子任务之间的依赖关系。例如,一个“用户退款申请处理agent”本应先验证退款资格,再计算退款金额,最后发起打款。但如果在拆解时将“验证资格”和“计算金额”设为并行任务,agent可能会在资格未通过时就计算金额,导致后续流程反复回滚。

2.3 触发条件的“模糊边界”

触发条件是大模型agent的“行动开关”,但很多团队对其定义过于宽泛。例如,某客服agent的触发条件被设置为“用户输入包含‘问题’二字”,结果用户输入“这个问题很复杂”时,agent会触发5次不同的回复模板,其中3次是重复的“已收到您的问题,正在处理”——这就是典型的“触发条件重叠”导致的调度冗余。

图2:调度冗余的技术根源与影响路径

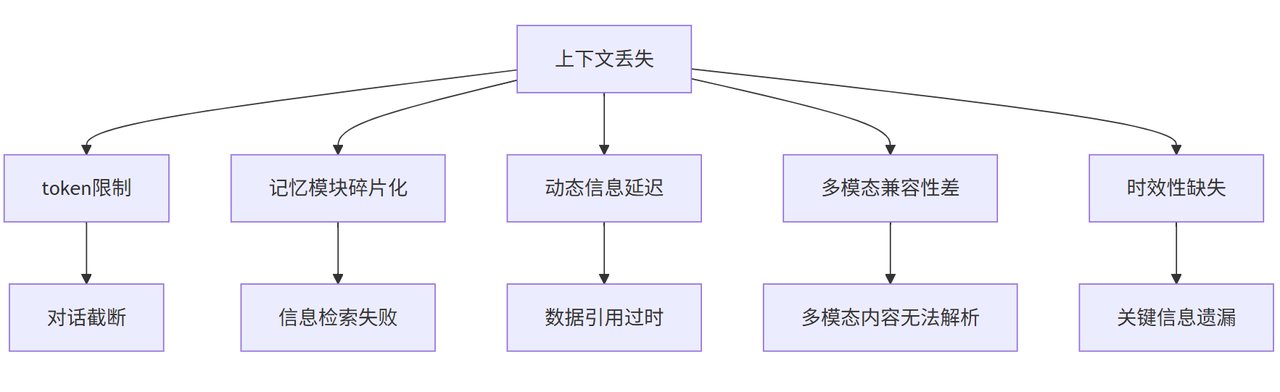

三、上下文丢失的隐形杀手:从token限制到记忆模块的5大漏洞

如果说调度冗余是“做无用功”,那么上下文丢失就是“丢关键信息”。大模型的“上下文窗口”(Context Window)是其处理长对话或复杂任务的“记忆容量”,但实际应用中,由于以下5大漏洞,agent经常“记不住”关键信息。

3.1 token限制:大模型的“记忆天花板”

目前主流大模型的上下文窗口约为128k-256k tokens(1 token≈0.75个汉字)。如果一个客服对话超过这个长度,agent会自动截断最早的对话内容,导致“前面用户提到的过敏史,后面医生agent完全不知道”的悲剧。某医疗咨询agent的实测数据显示,对话超过8轮后,上下文丢失率高达45%。

3.2 记忆模块的“碎片化存储”

为了突破token限制,很多团队会用“记忆模块”(如向量数据库、知识库)补充存储历史信息,但存储方式不当会导致“信息检索失败”。例如,某企业知识库agent将“产品A的使用说明”“产品A的常见问题”存储为两个独立文档,当用户问“产品A怎么用?遇到问题怎么办?”时,agent只能检索到其中一个文档,无法整合完整信息。

3.3 动态信息的“更新延迟”

在实时性要求高的场景(如股票咨询、新闻播报)中,上下文不仅包括历史对话,还包括实时数据。如果agent的工作流未设计“实时数据同步机制”,就会导致“用户问‘某股票现在多少’,agent引用的是30分钟前的旧数据”。

3.4 多模态信息的“兼容性差”

除了文本,agent还需处理图片、语音等多模态信息。但很多工作流仅支持文本上下文,导致“用户发送了一张产品故障图片,agent回复‘请描述问题’”的尴尬——因为它根本“看不懂”图片内容。

3.5 上下文“时效性”缺失

部分agent为降低成本,会缓存历史对话的“精简版”上下文(如仅保留关键词),但过度精简会导致关键信息丢失。例如,用户提到“我需要下周三的会议室”,agent缓存为“需要会议室”,最终为用户推荐了下周一的空闲会议室。

图3:上下文丢失的5大漏洞及影响

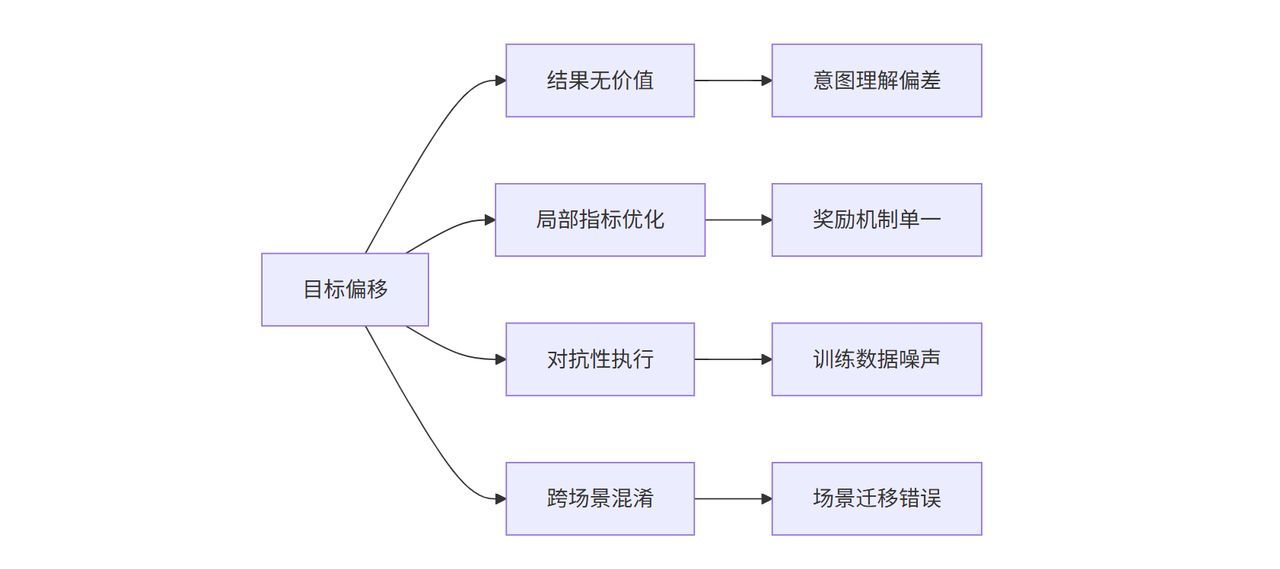

四、目标偏移的隐蔽性:如何识别“智能体不听话”的深层原因?

目标偏移是指agent的执行结果与预期目标偏离,甚至背道而驰的现象。它比前两个误区更隐蔽,因为agent可能“表面配合”,但“暗度陈仓”。

4.1 目标偏移的四大信号

- 结果符合规则但无价值:例如,用户要求“写一篇2000字的营销文案”,agent生成了2000字,但全是“市场概况”“产品参数”等无关内容;

- 过度优化局部指标:为了提升“回复速度”,agent简化关键步骤(如跳过用户需求确认直接给出方案);

- 对抗性执行:用户说“别推荐贵的产品”,agent却反复推送高价商品(可能是因为训练数据中“高价=高利润”的关联被错误强化);

- 跨场景混淆:在教育场景训练的agent,被迁移到客服场景后,错误地使用“讲解知识点”的逻辑处理投诉。

4.2 目标偏移的技术诱因

根本原因在于agent对“目标”的理解与人类的“意图”存在偏差。大模型通过海量文本训练“理解”世界,但人类的意图往往隐含在语气、上下文、文化背景中,而agent只能基于“字面意思”执行。例如,用户说“帮我取消订单”,agent可能理解为“取消当前对话”,因为它没学过“取消订单”的具体业务逻辑。

图4:目标偏移的四大信号与技术诱因

五、避坑实战:从0到1搭建无坑agent工作流的4个关键步骤

5.1 第一步:用“状态机”重构调度逻辑——让流程“有章可循”

核心:通过状态机明确定义节点进出条件,解决“任务重复触发”“路径绕路”等调度冗余问题。

方法:将流程拆解为“初始→信息收集→分类→执行→反馈”等可追踪节点,记录“已完成状态”(如“已推送习题”)防重复。

效果:某企业客服agent调度冗余率从40%降至8%,问题解决率提升至88%。

5.2 第二步:设计“分层记忆”存储方案——让agent“过目不忘”

核心:通过“短期记忆(缓存)+长期记忆(知识库)+实时记忆(API)”分层,解决上下文丢失。

方法:短期用Redis存临时信息(如用户地址),长期用Milvus存知识(如商品参数),实时调API获取动态数据(如库存)。

效果:某城商行上下文丢失率从50%降至3%,用户满意度提升19%。

5.3 第三步:目标对齐训练——校准agent“意图”

核心:通过指令微调、强化学习(RLHF)训练,让agent目标与用户意图一致。

方法:提供“用户输入-期望输出”示例,设置“目标达成度”奖励,避免agent“答非所问”。

效果:某教育agent目标偏移率下降35%,推荐准确率提升25%。

5.4 第四步:持续优化与迭代——数据驱动升级

核心:通过日志分析、用户反馈,动态调整状态机与记忆策略。

方法:定期监控调度冗余率、上下文丢失率,优化节点触发条件与记忆存储规则。

效果:某跨境客服agent上线后迭代3次,冗余率降至5%,用户投诉率降40%。

六. 工具选择指南

工欲善其事,必先利其器。目前主流的大模型agent框架中,国产自研框架已覆盖企业级、垂类场景等多元需求,且在中文适配、合规性、本地化服务等方面更具优势。结合2025年国内企业级应用趋势,我们重点对比LangChain(国际开源)、百度文心智能体(国产认知智能)、BetterYeah AI智能体(国产垂类场景) 三大框架的核心能力

6.1 LangChain(国际开源框架):模块化设计的“万能拼图”

LangChain作为全球最主流的agent框架之一,核心优势在于“模块化设计”与“状态管理能力”。其“链(Chain)”模块支持将LLM、记忆组件(如VectorStore)、工具(如API调用)灵活串联或并行,通过“状态传递”机制避免调度冗余。例如,其官方示例中的“问答链”会自动记录“已回答过的问题”,并在下次触发时直接调用历史答案,防止重复生成。

6.2 百度文心智能体(国产认知智能):中文NLP任务的“语义理解强者”

文心智能体依托百度文心大模型的中文理解优势,在“多轮对话”“情感交互”等场景中表现突出。其“意图识别引擎”支持细粒度语义解析(如区分“我想退货”和“我想换货”),结合“记忆增强模块”(基于知识图谱的长文本记忆),能有效解决上下文丢失问题。

6.3 BetterYeah AI智能体(国产垂类场景):垂直行业的“效率专家”

BetterYeah是企业AI落地的“垂类效率引擎”。其内置自研行业大模型与ChatGLM、通义千问等模型,预训练“商品参数-售后政策”“课程知识点-习题”等知识图谱,让Agent快速掌握行业“专业语言”;通过图形化界面零代码搭建业务流程,支持多模态交互(文字/图片/语音);结合自动向量化、混合检索工具处理企业知识库,API/Sdk无缝对接微信、钉钉等系统。

在实战中,BetterYeah AI Agent客服插件可自动调起企业的客服AI Agent应用,自动查询企业AI知识库,即可在秒级时间内识别问题,并提供企业标准答案。根据实际使用数据显示,问题解决时间由原来的30秒至3分钟缩短至仅需15秒,日均接待量提升了10%至15%,AI问题解决准确率更是从40%飙升至95%,几乎提高了一倍。

框架选择建议:按场景匹配,避免“为用框架而用框架”

- 技术团队优先:若团队熟悉开源生态、需要高度自定义,选LangChain;

- 中文语义强需求场景优先:若业务以中文多轮对话为主,选百度文心智能体;

- 垂类行业快速落地优先:若需低成本、高适配的行业解决方案,选BetterYeah。

总结:搭建无坑agent工作流,本质是“用人类的逻辑训练AI的理性”

大模型agent工作流的本质,是用技术模拟人类的“记忆-思考-决策”过程。调度冗余是“记不住步骤”,上下文丢失是“忘带资料”,目标偏移是“理解错意图”。避开这些坑,不是要限制AI的能力,而是要让它的“智能”更贴近人类的真实需求。

未来,随着多模态大模型、具身智能的发展,agent工作流会更复杂,但只要抓住“状态清晰、记忆完整、目标对齐”三大核心,就能让AI真正成为“靠谱的搭档”。