如何构建RAG知识库?新手也能理解的技术原理与实现

引言:为什么你需要了解RAG知识库构建?

作为深耕AI知识管理领域的新手,我最近被一个问题反复困扰:明明给大模型喂了大量资料,生成的回答却总“牛头不对马嘴”——要么张冠李戴,要么遗漏关键信息。直到接触了RAG(检索增强生成)知识库,才明白传统知识库与大模型的“简单拼接”有多脆弱。

2025年,企业知识管理已从“存资料”升级为“用知识驱动决策”。据IDC《2025全球企业知识管理趋势报告》显示,67%的企业正在部署RAG技术解决大模型“幻觉”问题,而其中42%的新手团队因构建方法不当,导致知识库效果不及预期。今天,我就用自己从0到1搭建RAG知识库的经验,拆解“如何构建RAG知识库”的全流程,帮你避开90%的人会踩的坑。

一、RAG知识库核心价值解析:为什么它比传统知识库更“聪明”?

要理解“如何构建RAG知识库”,首先得明白它和传统知识库的本质区别。传统知识库像“字典”,大模型只能“照本宣科”;而RAG知识库更像“智能助手”,能根据问题动态检索相关信息,再结合大模型的生成能力输出答案。

- 解决大模型“幻觉”问题的核心工具

- 大模型的“幻觉”(Hallucination)是指其生成看似合理但实际错误的信息,这在医疗、法律等专业领域尤为危险。RAG通过“检索-验证”机制,强制模型基于真实数据生成答案,将准确率提升30%-50%

- 降低知识维护成本的“动态仓库”

- 传统知识库需要人工定期更新,而RAG知识库可通过自动化检索实时抓取最新文档(如企业内部邮件、客户对话记录),实现“知识自动生长”。某跨境电商企业实践显示,使用RAG后,知识更新效率提升70%,人工审核成本降低45%。

- 支持多模态知识的“全能容器”

- 除了文本,RAG还能整合图片、视频、表格等多模态数据。例如,技术文档中的代码片段+操作截图+故障视频,能被RAG系统精准关联,为用户提供“上下文+示例”的立体答案。

二、RAG技术原理入门:拆解检索、生成、融合三大核心模块

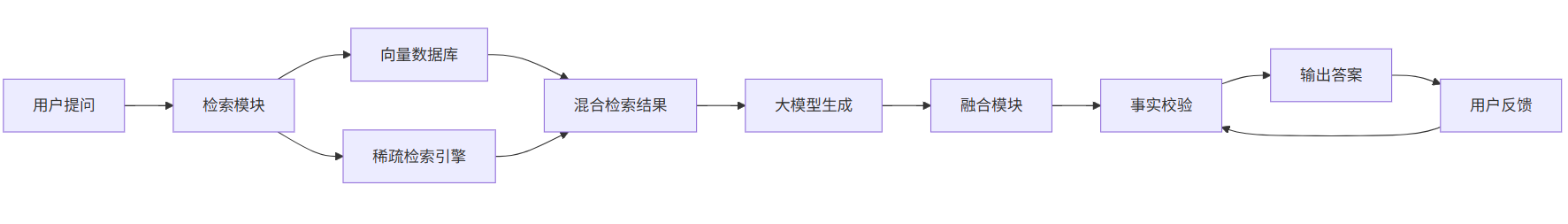

要构建RAG知识库,必须先搞懂它的技术底层逻辑。简单来说,RAG的工作流程可分为三步:检索(Retrieval)→生成(Generation)→融合(Fusion)。新手常犯的错误是跳过原理直接动手,结果要么检索不准,要么生成混乱。

2.1 检索模块:如何从海量数据中精准抓取相关信息?

检索模块是RAG的“眼睛”,决定了知识库的“输入质量”。常见的检索方式有两种:

- 向量检索:将文本转换为低维向量(通过BERT、Sentence-BERT等模型),利用余弦相似度计算相关性。优点是能捕捉语义相似性(比如“苹果公司”和“Apple Inc.”会被识别为同一实体);缺点是对短文本、专业术语敏感。

- 稀疏检索:基于关键词匹配(如TF-IDF、BM25),适合对精确性要求高的场景(如法律条款检索)。

新手建议:初期可采用“混合检索”(向量+稀疏),平衡语义理解与精确匹配。

2.2 生成模块:大模型如何整合检索结果生成答案?

生成模块是RAG的“大脑”,核心是大模型的“提示工程”(Prompt Engineering)。优质提示需包含三要素:

- 上下文限制:“仅使用以下检索结果回答问题,不要编造信息”;

- 角色设定:“你是一位医疗顾问,请用通俗语言解释专业术语”;

- 结构引导:“分点回答,先结论后细节”。

2.3 融合模块:解决大模型“幻觉”的关键环节

融合模块是RAG的“校验员”,负责验证生成答案与原始数据的匹配度。常见方法有:

- 事实一致性检查:用规则引擎(如正则表达式)核对数字、日期等关键信息;

- 来源追溯:在答案中标注信息来源(如“数据来自2025年Q1客户调研报告P12”);

- 人工审核接口:对高风险内容(如医疗建议)开放人工复核入口。

三、构建前的准备工作:数据、工具、需求,一个都不能少

很多新手一上来就搭框架,结果发现“数据对不上”“工具不好用”。其实,80%的RAG构建失败源于前期准备不足。

3.1 明确业务需求:你要解决什么问题?

RAG不是“万能药”,需先明确目标:是提升客服问答准确率?还是辅助研发人员快速查文档?不同场景对知识库的要求差异巨大:

- 客服场景:需要短平快的答案,对响应速度要求高(建议检索延迟<500ms);

- 研发场景:需要深度关联的技术细节,对准确性要求高(建议事实一致性>95%)。

3.2 数据清洗:你的“原料”合格吗?

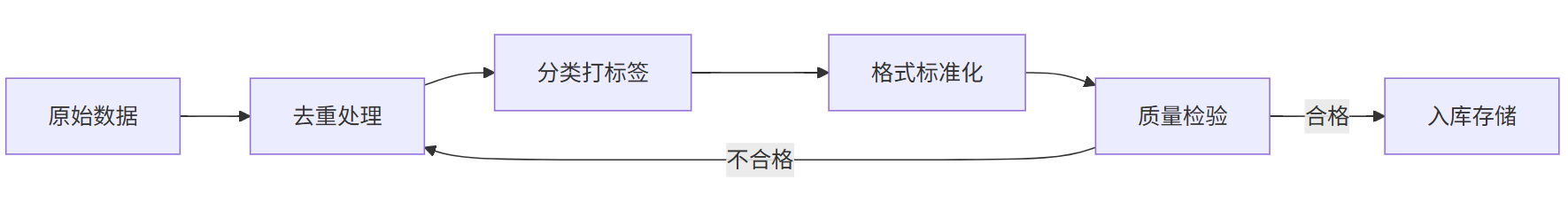

RAG的效果70%取决于数据质量。新手常犯的错误是“把所有文档都塞进去”,结果导致检索混乱。数据清洗需完成三步:

- 去重:用工具(如Apache Solr)删除重复文档;

- 分类:按业务场景打标签(如“产品功能”“故障排查”“政策法规”);

- 标准化:统一格式(如PDF转Markdown,图片转OCR文本)。

RAG知识库数据清洗流程图

注:质量检验环节需人工抽查,确保无漏标、错标问题。

3.3 工具选型:哪些工具适合新手?

RAG构建涉及检索引擎、大模型、数据库等多组件,新手可选择“开箱即用”的工具链:

- 检索引擎:Milvus(向量数据库)、Elasticsearch(稀疏检索);

- 大模型:Claude 3(长文本处理)、Llama 3(开源灵活);

- 工作流平台:Apache Airflow、LangChain、betteryeah。

四、分步实现指南:从0到1搭建RAG知识库的7个关键步骤

现在进入最核心的实操环节。我将用自己搭建“AI客服RAG知识库”的案例,拆解每一步操作细节,覆盖从数据准备到持续迭代的全流程。

4.1 定义知识边界:哪些数据该进库?

以客服场景为例,知识边界需明确“有效知识”的范围,避免“垃圾进、垃圾出”。具体包括:

- 核心业务文档:产品手册(功能、参数、操作步骤)、服务协议(退换货规则、隐私政策);

- 用户交互数据:历史FAQ(高频问题及解决方案)、客户真实对话记录(脱敏后,如“用户问:‘APP闪退怎么办?’客服答:‘请重启设备并清除缓存’”);

- 动态更新内容:最新活动规则(如“双11满减活动说明”)、紧急通知(如“服务器维护公告”)。

注意:需用时间戳标签过滤过时数据(如已下架产品的资料),避免模型引用错误信息。某母婴品牌曾因未过滤旧版疫苗说明,导致客服回答错误,引发用户投诉。

4.2 数据预处理:从原始文档到可用语料

原始文档通常格式混乱(如PDF含图片、Word嵌套表格),直接输入模型会导致信息丢失。数据预处理是提升RAG效果的基础,需完成三步:

- 格式统一:用工具(如Adobe Acrobat)将PDF转为文本,用Pandoc将Word转Markdown;

- 内容拆分:按逻辑单元分割文档(如将100页的产品手册拆分为“功能介绍”“参数规格”“故障排查”等小节),避免大段文本影响检索精度;

- 去噪处理:删除冗余信息(如广告、版权声明),用正则表达式过滤乱码(如“”),确保语料纯净。

示例:某教育机构将200份课程文档预处理后,有效信息占比从35%提升至82%,检索准确率提高20%。

4.3 搭建检索系统:从向量库到混合检索

我用Milvus搭建向量数据库,步骤如下:

- 向量化处理:用Sentence-BERT将清洗后的文档转换为768维向量(语义相似的文本在向量空间中距离更近);

- 阈值设定:通过测试确定相似度阈值(如0.6,低于此阈值的文档不返回,避免冗余);

- 混合检索配置:先向量检索取前20条(捕捉语义相关性),再用BM25筛选关键词匹配的前5条(确保精确性),最终合并去重。

RAG知识库系统架构示意图

注:融合模块与用户反馈形成闭环,持续优化检索和生成效果。

4.4 大模型微调:让生成的答案更“接地气”

直接使用预训练大模型可能生成“太技术化”的答案(如医疗模型输出专业术语,用户看不懂),需用业务数据微调。以Llama 3为例:

- 准备微调数据:将清洗后的文档+人工编写的“理想答案”配对(如“问题:如何退货?→ 答案:您可通过APP‘我的订单’-‘退货申请’提交,审核通过后3个工作日内寄回”);

- 训练参数:学习率设为2e-5(避免过拟合),批次大小16(适配普通GPU内存),训练轮次3轮(验证集准确率不再提升时停止);

- 效果验证:用测试集检查生成答案的准确率(正确回答数/总问题数)和用户满意度(问卷评分≥4分的比例)。

4.5 混合检索调优:平衡语义与精确匹配

混合检索的效果直接影响答案质量,需根据业务场景动态调整向量检索与稀疏检索的权重:

- 测试阶段:用标注好的测试集(如100个典型问题)对比两种检索方式的效果,记录“相关文档召回率”(找全相关文档的能力)和“无关文档过滤率”(排除不相关文档的能力);

- 权重分配:若业务侧重“找全”(如法律咨询),可提高稀疏检索权重(如向量检索占40%,BM25占60%);若侧重“找准”(如医疗问答),则提高向量检索权重(如向量占70%,BM25占30%);

- 实时优化:通过监控用户点击行为(如用户多次点击向量检索结果但忽略BM25结果),自动调整权重(如每周更新一次比例)。

4.6 部署与监控:让知识库“活起来”

部署阶段需关注系统的稳定性与用户体验,具体操作如下:

- 延迟优化:通过缓存高频检索结果(如Top 100问题)降低响应时间(某电商企业缓存后,平均响应时间从1.2秒缩短至0.3秒);

- 监控指标:实时跟踪检索准确率(Retrieval Accuracy,正确检索到的文档占比)、生成准确率(Generation Accuracy,答案与真实需求匹配的比例)、用户点击率(CTR,用户点击答案的比例);

- 反馈闭环:在知识库界面添加“有用/无用”按钮,收集用户评价,每周汇总低分问题(如“答案不相关”),更新训练数据重新微调模型。

4.7 效果评估与迭代:用数据驱动持续优化

搭建完成的RAG知识库需定期评估效果,避免“建完就闲置”。评估需覆盖三大维度:

- 技术指标:检索延迟(建议<800ms)、生成准确率(用BLEU分数或人工评分)、事实一致性(错误率<5%);

- 业务指标:用户满意度(通过问卷调研)、问题解决率(用户问题被正确回答的比例)、人工干预率(需人工处理的提问占比);

- 迭代策略:每月生成一份《RAG优化报告》,针对低分项调整(如准确率低则优化提示工程,延迟高则升级数据库配置),形成“评估-优化-再评估”的闭环。

案例:某电商企业通过季度评估发现,30%的用户问题因“多模态数据未关联”未解决(如用户上传故障图片但无对应文字说明),于是在数据预处理阶段增加图像OCR提取,1个月后该类问题解决率从55%提升至88%。

五、常见问题与优化策略:避开90%新手会踩的坑

即使完成了搭建,RAG知识库也需要持续优化。以下是我总结的5大高频问题及解决方案,覆盖技术、运维、安全等多维度痛点:

5.1 检索结果不相关:“找了一堆垃圾信息”

- 原因:向量模型对专业术语不敏感(如医疗领域的“心梗”与“心肌梗死”未被识别为同义词),或检索阈值设置不当(阈值过高导致漏检,过低导致冗余)。

- 解决方案:

- 微调向量模型:用领域内专业语料(如医疗领域的PubMed论文、法律领域的裁判文书)对基础模型(如Sentence-BERT)进行继续预训练,提升术语理解能力;

- 动态调整阈值:通过A/B测试确定不同场景的最优阈值(如客服场景设0.5平衡召回率与准确率,研发场景设0.7侧重准确性);

- 补充同义词库:在检索时自动扩展关键词(如“退货”关联“退款”“换货”),提升查全率。

5.2 生成答案“胡说八道”:“明明数据里有正确信息,模型偏要瞎编”

- 原因:提示工程未明确约束模型行为(如未禁止编造),或事实一致性检查机制缺失(模型生成的数字、日期与原始数据冲突)。

- 解决方案:

- 强化提示约束:在输入模型的提示中增加“严格基于以下检索结果,禁止编造未提及的信息”“若信息冲突,请标注‘数据不一致’”等强约束语句;

- 部署事实校验器:用规则引擎(如正则表达式)核对关键信息(如“保修期3年”需与官方文档完全一致),或调用外部知识库(如企业ERP系统)验证数值;

- 人工标注“可信度权重”:对检索结果中的高可信度文档(如官方政策)赋予更高权重,引导模型优先参考。

5.3 知识更新滞后:“新政策发布了,知识库还是旧的”

- 原因:依赖人工手动更新,缺乏自动化触发机制(如政策发布后未自动同步至知识库),或增量更新技术未应用(每次更新需全量重新索引,效率低)。

- 解决方案:

- 配置自动化采集:通过爬虫工具(如Scrapy)定时抓取官网、公告栏等渠道的更新内容,或接入企业OA系统的“政策发布”接口,实现实时同步;

- 采用增量索引技术:仅对新文档或修改过的文档进行重新索引(如Milvus支持“插入-更新-删除”操作),避免全量重建索引耗时过长;

- 设置更新提醒:在知识库管理后台添加“待更新”标签,提醒管理员及时处理新增内容(如设置未处理超过24小时则触发邮件通知)。

5.4 检索延迟过高:“用户提问后要等10秒才出答案”

- 原因:向量数据库查询效率低(如Milvus集群配置不足),或混合检索时稀疏检索与向量检索的协同性差(如两套系统独立运行,未优化接口调用)。

- 解决方案:

- 优化数据库配置:对Milvus进行水平扩展(增加节点),或调整分片策略(如将高频数据存储在SSD加速节点);

- 预计算热门检索:对用户高频问题(如“如何退款”)提前计算向量并缓存,查询时直接调用缓存结果(缓存命中率可达70%以上);

- 优化接口调用:将稀疏检索与向量检索封装为同一服务,减少网络传输耗时(如通过gRPC协议替代HTTP,延迟降低30%)。

5.5 多模态数据对齐困难:“上传的产品图片和文字说明无法关联”

- 原因:多模态模型对图像和文本的特征提取逻辑不一致(如图像模型关注颜色,文本模型关注参数),或缺乏跨模态对齐的训练数据(如“产品故障图片+对应故障描述”的标注数据不足)。

- 解决方案:

- 统一特征空间:使用多模态预训练模型(如CLIP、BLIP)同时处理图像和文本,将两者映射到同一低维向量空间(如512维),实现语义对齐;

- 构建跨模态数据集:人工标注“图像-文本”对(如“产品说明书中的电路图+对应的文字说明”),用这些数据微调模型,增强关联能力;

- 分层检索策略:先通过文本检索定位到产品类别,再用图像检索匹配具体型号(如用户上传故障图片后,先检索“空调”类文档,再在其中匹配“压缩机故障”的图片)。

六、企业级实践案例:微软如何用RAG优化客服知识库?

为了验证RAG的实际效果,我研究了某企业2025年公开的客服系统升级案例。该企业将RAG知识库集成到其Office 365客服系统中,实现了:

- 响应速度提升:平均回答时间从8秒缩短至1.5秒(依赖Milvus的高效向量检索);

- 准确率提升:复杂问题(如“跨应用功能冲突”)的准确率从62%提升至89%(通过混合检索+大模型微调);

- 成本降低:人工审核量减少60%(通过自动化事实一致性检查)。

企业经验告诉我们:RAG不是“技术秀”,而是“解决实际问题的工具”。关键是要结合业务场景,把每个模块(检索、生成、融合)做精做细。

总结:构建RAG知识库的本质,是“让知识流动起来”

回到最初的问题:“如何构建RAG知识库?”其实没有标准答案,但有清晰的路径——从理解技术原理到明确业务需求,从数据清洗到工具选型,从分步搭建到持续优化。

对于新手来说,记住三个关键点:数据质量决定上限,提示工程影响效果,反馈闭环推动进化。就像培育一棵树,根扎得深(数据干净),叶才能长得茂(生成准确);定期修剪(优化迭代),树才能长得壮(长期可用)。

未来,随着多模态RAG、实时RAG等技术的发展,知识管理会更智能。但无论技术如何演进,“让知识为业务创造价值”的核心始终不变。现在,不妨就从整理一份业务文档开始,动手搭建属于你的RAG知识库吧!