AI大模型(LLM)是什么?一站式深入解析【新手科普】

大模型 智能体 AI Agent

AI大模型的定义与原理

大模型(Large Model)是指在人工智能和机器学习领域中,具有大量参数和复杂结构的模型。它们通常由数百万甚至数十亿个参数组成,能够学习和模拟人类的决策过程。与传统的小模型相比,大模型能够处理更多的数据,进行更复杂的计算,从而在各种任务中表现出色。大模型的出现得益于计算能力的提升和大数据的普及,它们在自然语言处理、计算机视觉、语音识别等领域展现了前所未有的性能。

AI大模型的工作原理是通过深度学习技术,利用神经网络来模拟人脑的工作方式。通过训练大量的数据,模型能够识别模式、做出预测,并在多种场景下应用其“知识”。

这类模型的特点是能够处理复杂的任务,如语言翻译、图像识别、自然语言处理等。它们的学习能力和适应性极强,能够不断优化自己的性能。

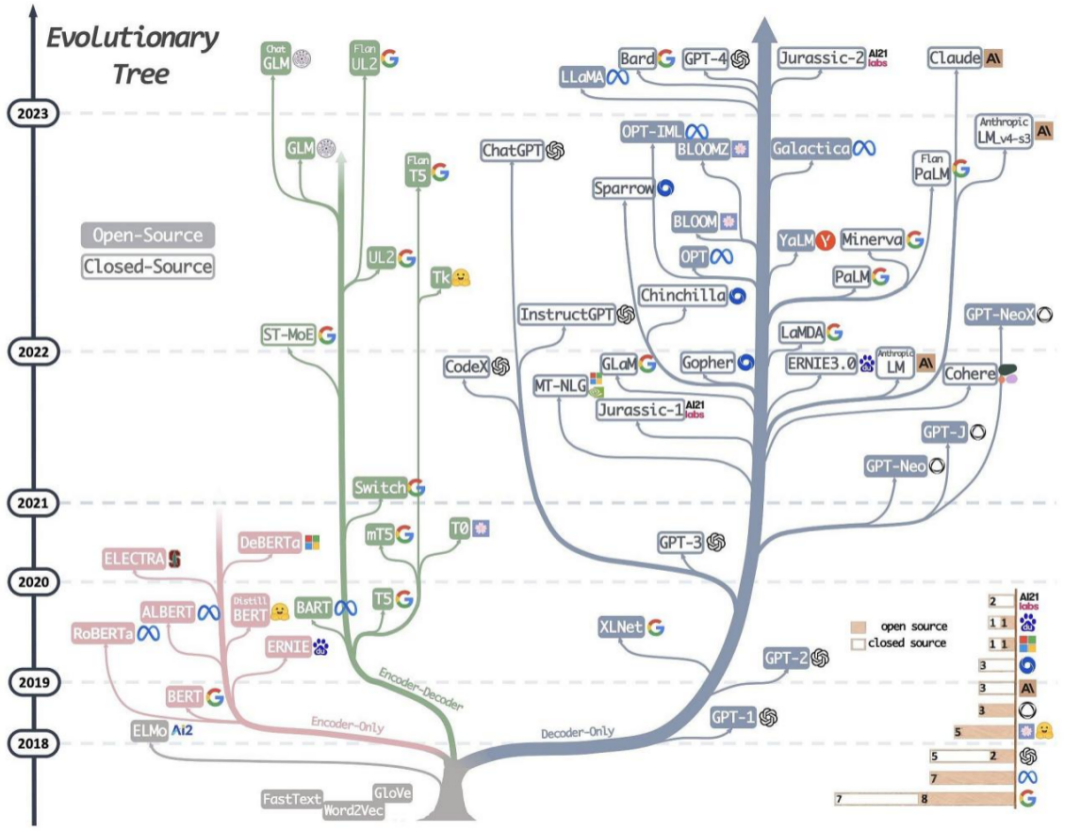

AI大模型的发展历程

AI大模型的发展历程可以分为三个主要阶段:萌芽期、沉淀期和爆发期。

- 在1990年代至2005年的萌芽期,神经网络模型开始起步,并逐渐成为人工智能领域的研究热点。在这一阶段,深度学习的概念被提出,为后续AI大模型的发展奠定了理论基础。然而,由于数据量和算力的限制,这一时期的模型规模较小,应用场景也相对有限。

- 2006年至2019年是AI大模型的沉淀期。在这一阶段,Transformer架构的提出,为大模型算法基础的建立提供了关键的技术突破。此外,生成对抗网络(GAN)的出现,也开启了深度学习在生成模型领域的新篇章。这些技术的积累和沉淀,为大模型的进一步发展打下了坚实的基础。

- 进入2020年至今的爆发期,以GPT系列模型为代表的AI大模型开始引领技术潮流。GPT系列模型通过大规模预训练的方式,极大地提升了自然语言处理的能力。特别是ChatGPT的出现,通过在多轮对话和上下文理解方面的特定训练,使得AI大模型能够更加自然地与人类交流。这一系列的突破,使得AI大模型开始广泛应用于各个行业,并逐步进入普及阶段。

随着大模型(LLM)的不断进步和应用的深化,它们正在推动人工智能技术向更加智能化、多模态化和个性化的方向发展。从早期的基础研究到今天的商业化应用,AI大模型正不断突破极限,展现出巨大的潜力和广阔的前景。

AI大模型的技术支撑

AI大模型之所以能够实现强大的功能,其背后的技术基石是算力底座、数据基础和算法创新的有机结合。

算力底座为AI大模型提供了必要的计算资源。随着AI芯片技术的飞速发展,深度学习框架的不断优化,以及算力集群的广泛部署,AI大模型得以在大规模数据上进行高效的训练和推理。这其中,GPU、TPU等专用芯片的应用大大加快了训练速度,而云计算和分布式计算技术则提供了必要的存储和计算能力。

数据基础则是AI大模型智能化的关键。高质量的数据对于模型的训练至关重要,随着数据收集和处理能力的增强,AI大模型能够接触到并学习来自各行各业的海量数据。同时,数据清洗、标注和管理等过程的自动化,也为模型的训练提供了可靠保障。

算法创新是推动AI大模型发展的核心驱动力。Transformer架构的提出,通过自注意力机制有效解决了长期依赖问题,极大提升了自然语言处理的性能。而GPT模式的出现,通过预训练和微调的方式,实现了模型在不同任务上的快速适配和优化。这些算法的创新,不仅提高了模型的性能,也为模型的实际应用提供了更多的可能性。

综上所述,算力底座、数据基础和算法创新共同构成了AI大模型的技术基石。随着这些技术的不断进步,我们有理由相信,AI大模型将在未来展现出更加强大的能力。

AI大模型的核心能力

AI大模型凭借其庞大的参数规模和海量数据的训练,已经发展出三大核心能力,这些能力使其在多个领域都显示出巨大的应用潜力。

1、大语言理解与生成能力

AI大模型能够理解复杂的语义和语境,不仅可以准确回答问题,还能生成连贯、富有创造性的文本内容。这使得它们在文本翻译、内容创作、智能客服等领域具有极高的应用价值。

2、AI大模型具备处理多模态数据的能力

除了文本之外,它们还可以融合图像、视频、声音等多种数据类型,实现更为丰富的交互体验。例如,通过结合图像识别技术,AI大模型可以理解图片内容并生成相应的描述或故事。

3、AI大模型拥有强大的自适应学习能力

通过不断的学习和优化,模型能够适应新的任务和环境,实现快速的知识迁移和应用扩展。这使得AI大模型不仅能够服务于特定领域,还能够灵活应对未来可能出现的新挑战。

AI大模型的核心能力不限于上述几点,随着技术的不断进步和应用的不断深入,更多潜在的能力和应用场景还将被陆续开发和探索。未来,AI大模型有望在更广泛的领域发挥关键作用,推动整个社会的智能化进程。

BetterYeah 与AI 大模型(LLM)

BetterYeah 作为国内领先的企业级AI应用开发平台,已接入了60+大模型,覆盖了市面所有主流AI大模型,还提供强大的AI工作流、知识库、数据库、第三方插件等能力,无论企业内部团队编程技能如何,都能快速创建由AI大模型驱动的企业级智能体应用。

BetterYeah提供从AI应用开发、训练到部署的一站式服务,助力企业在客服、销售、营销等核心业务领域实现智能化升级。金融、电商、教育、零售等行业众多头部客户已经通过我们的企业AI解决方案加速业务发展。

了解更多,欢迎访问BetterYeah AI Agent官网。

AI大模型的特点

- 巨大的规模: 大模型包含数十亿个参数,模型大小可以达到数百 GB 甚至更大。巨大的模型规模使大模型具有强大的表达能力和学习能力。

- 涌现能力:涌现(英语:emergence)或称创发、突现、呈展、演生,是一种现象,为许多小实体相互作用后产生了大实体,而这个大实体展现了组成它的小实体所不具有的特性。引申到模型层面,涌现能力指的是当模型的训练数据突破一定规模,模型突然涌现出之前小模型所没有的、意料之外的、能够综合分析和解决更深层次问题的复杂能力和特性,展现出类似人类的思维和智能。涌现能力也是大模型最显著的特点之一。

- 更好的性能和泛化能力: 大模型通常具有更强大的学习能力和泛化能力,能够在各种任务上表现出色,包括自然语言处理、图像识别、语音识别等。

- 多任务学习: 大模型通常会一起学习多种不同的 NLP 任务,机器翻译、文本摘要、智能问答系统等。这可以使模型学习到更广泛和泛化的语言理解能力。

- 大数据训练::大模型需要海量的数据来训练,通常在 TB 以上甚至 PB 级别的数据集。只有大量的数据才能发挥大模型的参数规模优势。

- 强大的计算资源: 训练大模型通常需要数百甚至上千个 GPU,以及大量的时间,通常在几周到几个月。 迁移学习和预训练: 大模型可以通过在大规模数据上进行预训练,然后在特定任务上进行微调,从而提高模型在新任务上的性能。

- 自监督学习: 大模型可以通过自监督学习在大规模未标记数据上进行训练,从而减少对标记数据的依赖,提高模型的效能。

- 领域知识融合: 大模型可以从多个领域的数据中学习知识,并在不同领域中进行应用,促进跨领域的创新。

- 自动化和效率:大模型可以自动化许多复杂的任务,提高工作效率,如自动编程、自动翻译、自动摘要等。

AI大模型的分类

大模型可以根据它们处理的数据类型和应用领域进行分类。

按照输入数据分类,大模型主要分为语言类、视觉类、多模态类三类:

语言大模型(NLP):它们专门处理文本数据,理解自然语言。比如,GPT系列模型可以生成文章或回答问题。视觉大模型(CV):它们处理图像数据,进行图像识别和分析。比如,VIT系列模型可以识别照片中的物体。

多模态大模型:它们可以处理多种类型的数据,如文本、图像和声音。比如,DALL-E模型可以根据描述生成相应的图像

按照应用领域的不同,大模型主要可以分为 L0、L1、L2 三个层级:

通用大模型 L0:是指可以在多个领域和任务上通用的大模型。它们利用大算力、使用海量的开放数据与具有巨量参数的深度学习算法,在大规模无标注数据上进行训练,以寻找特征并发现规律,进而形成可“举一反三”的强大泛化能力,可在不进行微调或少量微调的情况下完成多场景任务,相当于 AI 完成了“通识教育”。

行业大模型 L1:是指那些针对特定行业或领域的大模型。它们通常使用行业相关的数据进行预训练或微调,以提高在该领域的性能和准确度,相当于 AI 成为“行业专家”。

垂直大模型 L2:是指那些针对特定任务或场景的大模型。它们通常使用任务相关的数据进行预训练或微调,以提高在该任务上的性能和效果。

为什么现在的AI大模型更智能?

现代AI大模型更智能,主要原因包括:

- 计算能力提升:GPU和TPU等硬件进步及分布式计算技术增强了训练效率。

- 海量数据:大数据时代提供了丰富且多样的数据源,使模型能捕捉复杂模式。

- 模型架构创新:Transformer等新架构提升了模型的表达能力和性能。

- 预训练与迁移学习:生成式预训练和迁移学习技术提高了模型的泛化能力。

- 优化算法改进:现代优化算法和正则化技术提高了模型的性能和泛化能力。

- 对比学习与自监督学习:这些技术提高了模型在无监督环境下的学习能力。

- 多模态学习:融合多种数据类型,使模型在跨模态任务中表现出色。

- 强化学习:增强了模型在复杂决策任务中的智能化表现。

这些因素共同推动了大模型的发展,使其在多个任务和应用场景中表现更为智能。

AI大模型与AI智能体

AI大模型和AI智能体是人工智能领域中的两个不同的概念,它们在功能、设计和应用方面均有所区别:

1、定义

AI大模型:通常指的是使用大量数据训练的深度学习模型,如自然语言处理模型(例如GPT-3)或图像识别模型,它们能够处理和生成复杂的数据输出。

AI智能体:指的是能够在特定环境中自主操作和做出决策的系统,它可能包含感知、学习、推理和交互的能力。

2、功能范围

AI大模型:专注于特定任务或领域,如语言翻译、文本生成、图像识别等。

AI智能体:可能包含多种功能,如感知环境、学习、决策制定和执行任务。

3、交互能力

AI大模型:通常不涉及与用户的直接交互,它们更多地是作为数据处理和生成的工具。

AI智能体:具有与用户或其他系统进行交互的能力,能够响应输入并执行相应的动作。

4、自主性

AI大模型:通常不具备自主性,它们按照预设的算法和数据进行操作。

AI智能体:具有一定程度的自主性,可以根据环境变化和任务需求自主做出决策。

5、应用场景

AI大模型:广泛应用于内容生成、数据分析、模式识别等领域。

AI智能体:应用于需要自主操作和交互的场景,如机器人、自动驾驶汽车、虚拟助手等。

6、学习和适应能力

AI大模型:可能具备学习能力,但通常局限于模型训练阶段。

AI智能体:通常设计有在线学习和适应环境变化的能力。

7、集成复杂性

AI大模型:可能相对单一,专注于特定类型的数据处理。

AI智能体:可能需要集成多种技术,如感知、学习、规划和执行等。

8、用户期望

AI大模型:用户期望它们能够提供高质量的输出,但不一定需要交互性。

AI智能体:用户期望它们能够理解和响应用户的需求,提供个性化服务。

两者之间也存在一定的联系,AI智能体可能会使用AI大模型作为其决策和交互能力的一部分。在实际应用中,它们可以相互补充,共同构建更加复杂和高级的人工智能系统。大模型为智能体提供了强大的支持,使其能够更准确地理解环境和人类的指令,从而做出更智能的决策。智能体依赖于大模型进行数据分析、预测和决策,能够在复杂的环境中表现出色。

AI大模型局限性:幻觉问题

AI大模型的“幻觉”(hallucinations)问题指的是模型在没有足够证据的情况下生成错误或误导性的输出。这通常发生在文本生成、图像识别和生成等领域。以下是一些解决幻觉问题的方法:

- 数据质量:确保训练数据的质量,避免使用有误导性或不准确的数据。

- 数据多样性:增加训练数据的多样性,确保模型能够覆盖不同的情况和场景。

- 数据清洗:对训练数据进行清洗,移除或修正错误和不一致的数据。

- 模型正则化:使用正则化技术,如Dropout、权重衰减等,以减少模型的过拟合。

- 限制生成:为生成任务设置明确的边界和约束,避免生成不切实际或错误的信息。

- 模型评估:定期对模型进行评估,使用验证集和测试集来检测和纠正幻觉问题。

- 集成学习:使用多个模型的集成,以减少个别模型的幻觉倾向。

- 后处理:在模型输出后进行后处理,如事实核查或逻辑推理,以减少错误。

- 多模态学习:结合不同模态的数据,如文本、图像和声音,以提供更全面的信息。

- 人类监督:在关键领域,如医疗和法律,引入人类专家的监督和验证。

- 对抗训练:使用对抗训练技术,让模型学会识别和抵抗错误信息。

- 上下文理解:增强模型对上下文的理解能力,以便更准确地生成或识别信息。

通过这些方法,可以在一定程度上减少AI大模型的幻觉问题,提高其输出的准确性和可靠性。然而,这是一个持续的过程,需要不断的研究和改进。